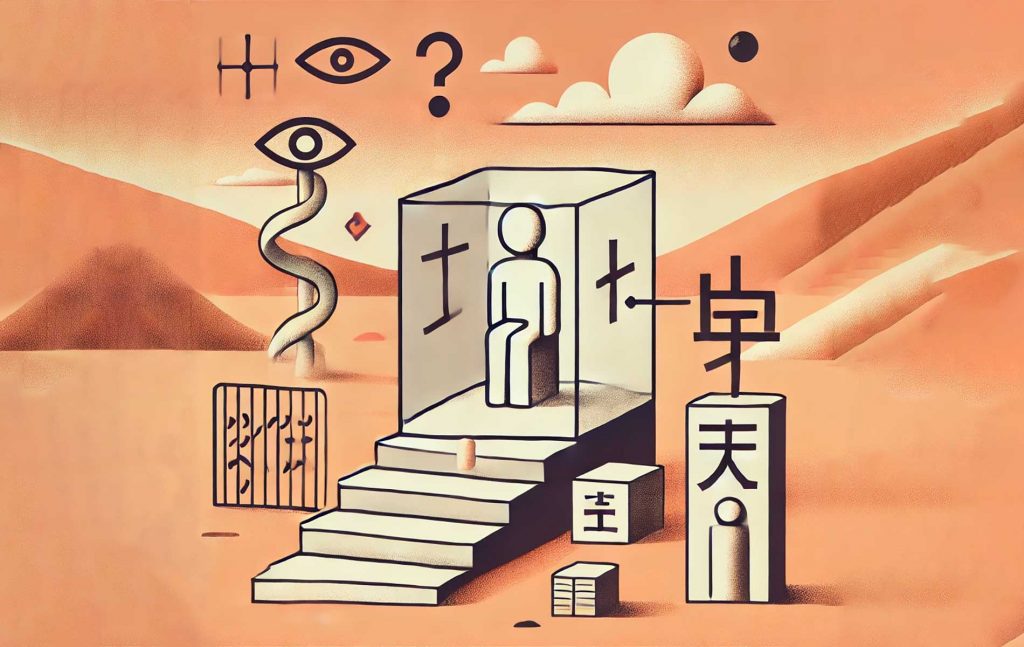

Das chinesische Zimmer

Das Gedankenexperiment des „Chinesischen Zimmers“ wurde von dem Philosophen John Searle entwickelt und dient als Argument gegen die Vorstellung, dass eine Maschine allein durch das Verarbeiten von Symbolen ein echtes Verständnis oder Bewusstsein erlangen kann. Es zielt darauf ab, die Grenzen der „starken Künstlichen Intelligenz“ (KI) aufzuzeigen, die behauptet, dass Maschinen nicht nur wie Menschen handeln, sondern auch tatsächlich denken und verstehen können.

Das Szenario:

Stellen Sie sich eine Person vor, die in einem geschlossenen Raum sitzt und kein Chinesisch versteht. In diesem Raum befinden sich eine Reihe von Handbüchern in der eigenen Sprache (zum Beispiel Deutsch), die detaillierten Anweisungen enthalten, wie chinesische Schriftzeichen zu verarbeiten sind.

Diese Anweisungen beschreiben systematisch, welche chinesischen Zeichen als Antworten auf eingehende Zeichenketten (Fragen in Chinesisch) ausgegeben werden sollen. Die Person im Raum folgt diesen Anweisungen präzise, ohne die Bedeutung der Zeichen zu verstehen. Sie arbeitet lediglich nach den vorgegebenen Regeln, um die korrekten Ausgaben zu erzeugen.

Der Ablauf:

Von außen wird eine Eingabe in chinesischen Schriftzeichen in den Raum gegeben (z.B. eine Frage). Die Person im Raum verwendet die Handbücher, um die korrekten Antworten zu generieren, indem sie die Symbole gemäß den Anweisungen einsetzt.

Die Person gibt dann eine Antwort in chinesischen Schriftzeichen zurück, die nach außen hin korrekt und sinnvoll erscheint.

![]()

Der Eindruck:

Für einen Außenstehenden scheint es so, als würde die Person im Raum Chinesisch verstehen, da die Ausgaben den eingehenden Fragen angemessen sind. Dies erweckt den Eindruck, dass im Raum ein Verständnis für die chinesische Sprache vorhanden ist.

Der Kern des Arguments:

John Searle argumentiert, dass, obwohl die Person die Anweisungen genau befolgt und richtige Antworten gibt, sie in Wirklichkeit kein Chinesisch versteht. Sie arbeitet lediglich nach einem syntaktischen Regelwerk ohne Verständnis der Semantik – also der Bedeutung der Symbole.

Das Experiment illustriert, dass das bloße Verarbeiten von Symbolen nach Regeln (Syntax) nicht ausreicht, um Bedeutung (Semantik) oder echtes Verständnis zu erzeugen.

Schlussfolgerung:

Searle zieht daraus den Schluss, dass selbst wenn ein Computerprogramm so konstruiert ist, dass es in einer natürlichen Sprache wie Chinesisch korrekt kommuniziert, es dies nur aufgrund der Manipulation von Symbolen ohne Verständnis tut. Ein solches Programm zeigt keine intentionalen Zustände, keine Bedeutungszuschreibung und kein Bewusstsein.

Dies bedeutet, dass die „starke KI“-Behauptung – dass eine Maschine durch das Ausführen des richtigen Programms ein echtes Verständnis erlangen kann – falsch ist. Die Simulation von Intelligenz oder Verständnis ist nicht dasselbe wie tatsächliches Verständnis.

Bedeutung und Kritik:

Das Gedankenexperiment des „Chinesischen Zimmers“ wurde kontrovers diskutiert und hat eine breite Debatte darüber ausgelöst, was „Verstehen“ und „Bewusstsein“ in Bezug auf Maschinen bedeutet.

Kritiker argumentieren, dass Searles Experiment die Möglichkeit eines emergenten Verständnisses oder einer Form von funktionalem Bewusstsein in verteilten Systemen (wie Netzwerken oder KIs) nicht angemessen berücksichtigt.

Befürworter sehen darin jedoch eine starke Kritik an der Vorstellung, dass mechanische oder rechnerische Prozesse ausreichen, um menschliches Verständnis zu reproduzieren.

Das „Chinesische Zimmer“ bleibt eine zentrale Metapher in der Diskussion um die Grenzen der Künstlichen Intelligenz und die Natur von Bewusstsein und Verstehen.